随着人工智能技术的迅猛发展,企业对 AI 的应用需求正在经历一场前所未有的变革。2024年,各行各业不再仅仅是 AI 技术的旁观者或初学者,而是转变为需求主导的实践者,正不断在具体应用场景中寻求 AI 的“最优解”。

在这个关键的转折点上,AI 技术如何塑造未来,基础设施如何适应新的技术需求,如何加快算力供给,从而为业务创造更大的价值等“疑云”,正不断被行业领袖和技术先锋们缓缓揭晓。

AI 创变应用、技术、基础架构未来范式

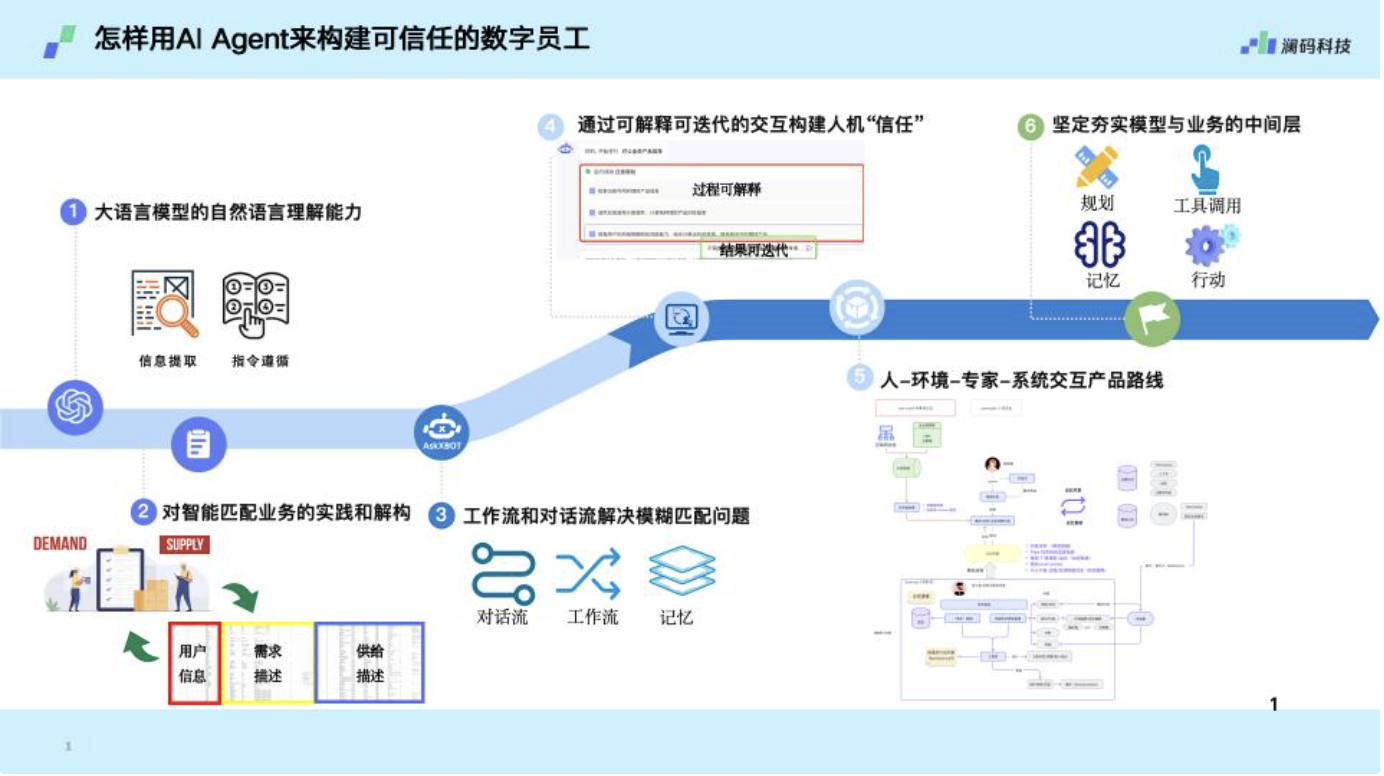

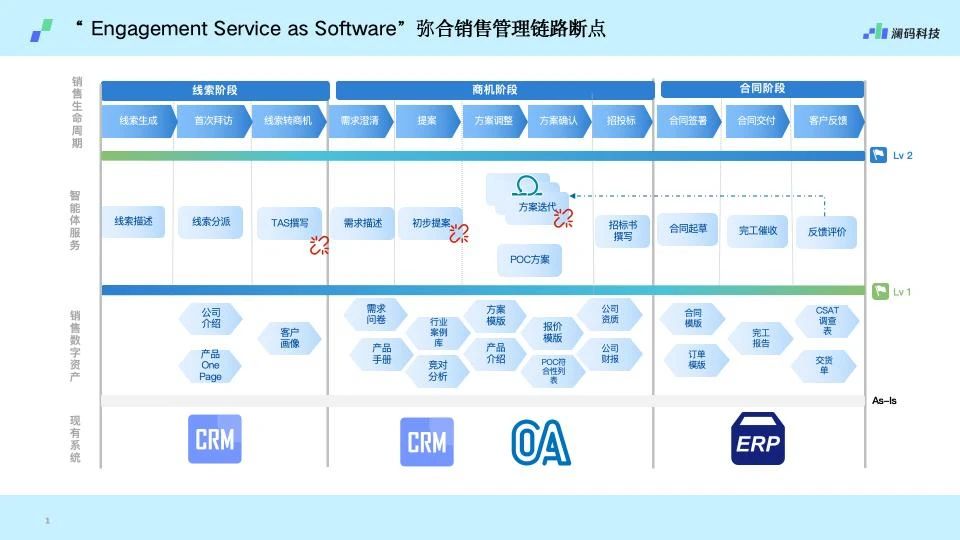

“反转”是澜码科技联合创始人周元剑在应用侧对于2024年 AI 在场景和企业需求层面的直观感悟。“去年,我们还在向客户介绍 AI 模型和应用案例,而今年,客户们已经带着具体的应用场景来到我们面前,这表明他们已经准备好将 AI 应用到各种业务中。”

尽管刚刚成立不久,定位 AI Agent 平台的澜码科技已经服务了以银行行业为主的诸多行业头部客户。周元剑深知,AI 不仅要赋能企业,更要赋能员工,以“人”为基础,才构筑起屹立不倒的能高楼大厦。“我们希望我们的平台未来赋能企业里面各种各样的员工,让他们每个人都能设计自己的大模型助手。”周元剑如是说。

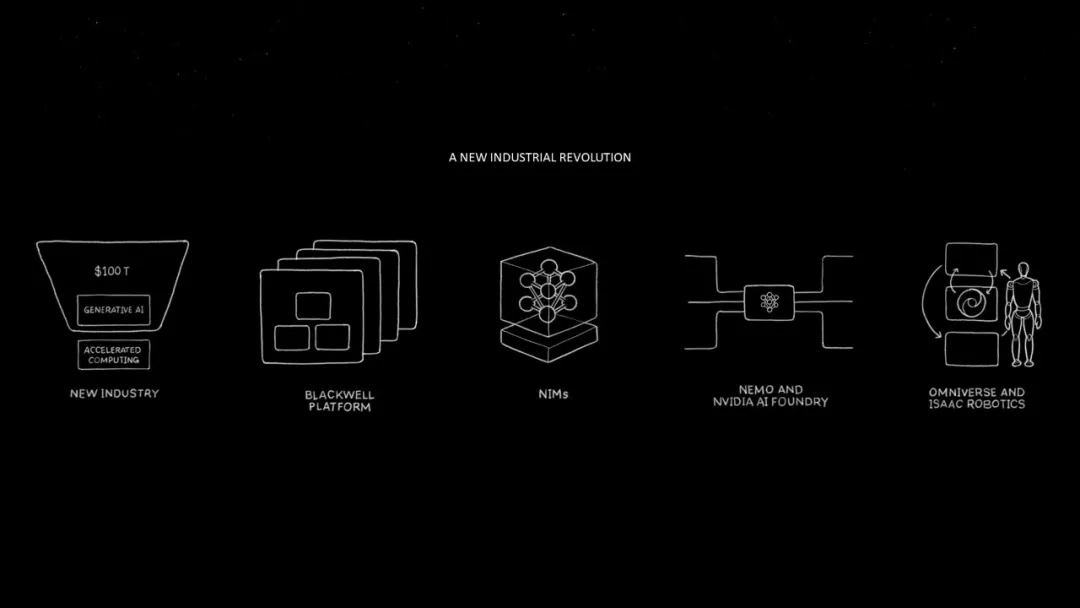

GTC 是 AI 技术侧的“风向标”。在刚刚过去的 GTC 2024上,NVIDIA 提出了一系列引人注目的技术发布和战略计划。

推理运行成本和能耗降低多达 25 倍 Blackwell 平台,让万亿参数大模型可以在每一个企业应用部署;NVLink + InfiniBand 网络、Spectrum-X 以太网架构的高吞吐量有效缓解网络延迟等问题; 推理加速、NIM微服务、算力汇聚成 NIM Microservice,构成了 AI Foundry( AI 铸造厂)的三大支柱;为机器人准备的三类电脑——DGX、OVX、AGX,分别对应 AI、仿真,以及机器人开发平台......

NVIDIA 企业级软件服务专家张旭坦言,这些新技术,呈现出 NVIDIA 面向“下一代工业革命”的趋势表达与能力展现。

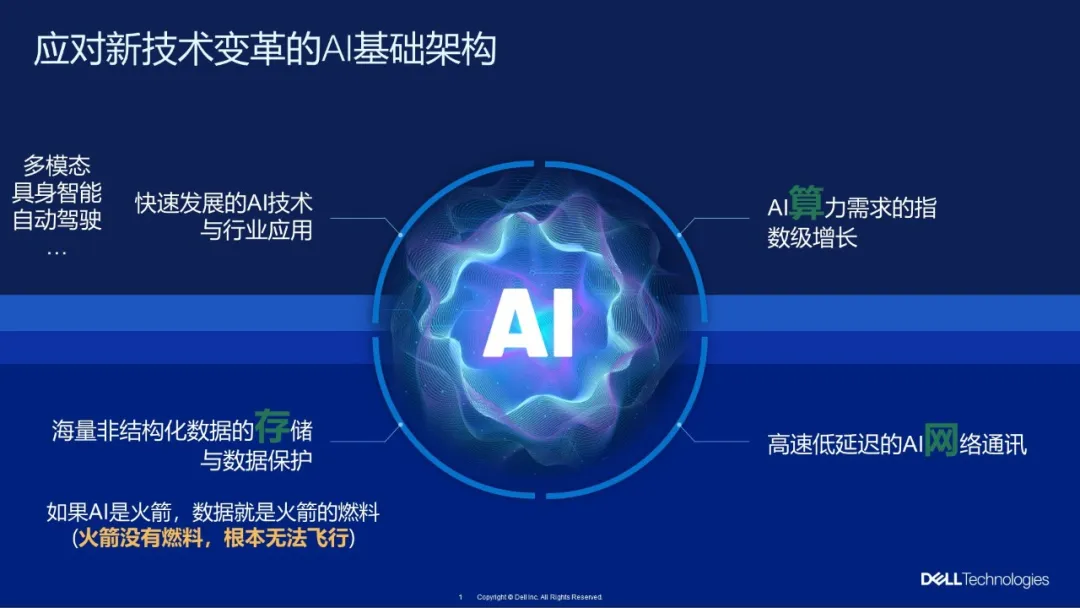

在基础架构层面,戴尔科技集团AI企业技术架构师,全球 CTO 大使吴跃谈到三点 AI 和基础架构的融合趋势。

其一,随着 AI 计算需求的增长,计算模式从主要依靠 CPU 向包含 GPU 的异构计算转变。这种变化不仅提高了处理能力,还对数据中心的建设、供电和散热系统产生了重大影响。云技术和虚拟化在融入 GPU 技术的过程中也在快速发展,预示着异构计算在企业中的重要性将持续上升。

其二,数据是构建有效 AI 模型的关键。随着数据应用的增加,基础设施需适应支持数据的全生命周期,包括采集、治理、存储和保护。处理非结构化数据的需求正在增长,未来数据平台的构建和数据管理策略将成为基础设施的核心。

其三,随着 AI 的发展,计算需要在接近应用地点的地方进行,以满足低延迟需求。因此,计算的地理位置正在变化。边缘计算的重要性在增加,它与 AI 计算的结合是IT领域未来的一个关注点。

架构革新:AI 时代需要怎样的基础架构?

AI 应用数据量日益庞大、摩尔定律陷入瓶颈,为基础架构带来了诸多新的挑战。

周元剑指出,随着参数量的增加,模型也随之更“大”,这直接导致了对计算资源的巨大需求。此时。一张显卡显然无法满足需求,而需要多卡甚至多机并行处理。然而,这种需求不仅增加了硬件成本,也对现有的技术架构提出了更高的要求。

在应用场景的实时响应层面,周元剑强调了响应速度的重要性。“在诸如客服等需要快速响应的场景中,模型的延迟时间可能达到几十秒,这对用户体验构成了极大的挑战。”他解释说,当用户期望即时回应时,延长的响应时间可能导致用户不满,从而影响企业的服务质量和客户满意度。

在张旭看来,解决生成式 AI,特别是大型 AI 模型在落地过程中系统层面和监管层面的问题至关重要。他强调,NIM Microservice(推理微服务)便是那把打破桎梏的利器。

NIM Microservice 通过一系列封装和优化,可以让大模型运行在所有 CUDA GPU 上,这极大程度地提升了大模型的应用灵活性和部署效率。NIM Microservice 还能够在企业面对大规模数据处理需求时提供高效的服务。张旭进一步解释说:“不论是来自开源社区,还是商业化,抑或是 NVIDIA 自己的大模型,NIM Microservice 都能通过合适的 CUDA 版本,与 TensorRT 等技术协同工作,优化的内存管理,最终将企业封装、输出成一个工业级 API。”

张旭坦言,在工程化和企业级服务过程中,NIM 提供的微服务使得大型模型的需求可以通过一组或多组 NIM 进行分解和解决。更是通过与戴尔等企业的战略合作,打造出更多完整的企业级解决方案,以应对各种复杂的业务需求。

正如张旭所言,在与 NVIDIA 的合作下,戴尔打造出算、网、存、管于一体的 AI 平台解决方案。

在计算维度,吴跃深知 GPU 硬件技术与软件协同发展的必要性。“实际上,从基础设施的角度,我们希望最大化地发挥整个 GPU 的效能。”吴跃指出,戴尔正在这方面进行大量工作,以确保其服务器能够充分利用 GPU 的计算能力。

关于网络通信,吴跃提到了戴尔与 NVIDIA 的合作,特别是基于 InfiniBand 技术的高带宽传输网络,这对于大型 GPU 集群的性能至关重要。“这种高带宽传输网络是我们构建 AI 数据中心的关键。”他这样说。

存储方面,GPU 内部数据交互、设备层面的高速通信,以及节点之间的存储通信瓶颈亟需解决。吴跃坦言:“随着 HBM 显存等 GPU 的高速通信计算快速技术,以及戴尔服务器机型支持的多卡间高速通信技术——NVLink、PCI-E 等快速发展,可以有效提升通讯效能”

在 AI 数据中心管理层面,吴跃特别强调了能耗问题和绿色数据中心概念。他直言道:“节能降耗是戴尔在助力构建成规模化 AI 数据中心时,需要考量的重要一环。目前,戴尔已经拥有液冷解决方案,包括开发了冷板式液冷和浸没式液冷技术。”

解决之道:加强合作 创新技术与基础架构

在谈及算法、软件如何影响未来基础设施的问题时,周元剑首先概述了 AI 应用的三个核心特点——数据密集、计算密集和智能密集。他认为,这些特性要求 AI 系统能够快速处理大量数据并实现高效的计算。

周元剑指出,这些需求导致的现象是 AI 任务虽然不频繁,但每个任务的价值较大。这对于基础设施提出了更高的要求,不仅需要强大的处理能力,还要有快速的数据访问能力。

周元剑预见,未来基础设施的变化将主要体现在两个方向。

第一,改进现有系统。硬件在 IO、内存或显存、通信方面的大幅加速。这些改进将支持更复杂的AI操作,满足数据密集和计算密集的需求。

第二,硬件集成的创新。未来可能出现如系统芯片(SOC)这样的更整体的硬件解决方案。这些解决方案不再区分显存与内存,从而规避现有瓶颈。这样的整合可能带来更高的数据处理效率和更快的响应速度。

为企业搭建 AI 基础设施,正是 NVIDIA 与戴尔合作的初衷。目前,戴尔对外提供的解决方案已经融入 NVIDIA 全栈企业级服务软件“NVIE”。

张旭强调,通过“NVIE”,NVIDIA 能提供端到端的数据加速服务,以便于让 AI 开发者,只需关注 AI 服务的构建,减轻基础架构层面的工作。“NVIE”包括功能、产品、高度监管三个分支。

功能分支即以月为单位,保证的数据科学家能够体验到最新最快的 AI 环境和模型。产品分支专注于 API 的稳定性和系统的整体安全,提供期稳定的平台,其生命周期为9个月,并每6个月进行一次更新。高度监管的分支可提供三年的生命周期,每两年半发布一次新版本。通过这种周期性的更新和维护,在软件发布时及时清除安全漏洞,并通过定期扫描确保系统的稳定运行。既满足了 AI 开发者对新技术的尝鲜需求,又保证了 AI 服务的稳定性。

针对戴尔与 NVIDIA 的合作,吴跃表示,戴尔运用 NVIDIA 的“能力”推出了一系列创新的产品和解决方案,旨在加强其在企业级市场的领导地位并加速AI技术的应用。其中包括新一代 GPU 加速服务器 PowerEdge XE9680,这款服务器支持最新一代的 NVIDIA Blackwell 平台,为处理高性能计算任务提供强大的支撑。

在数据存储领域,戴尔推出了 AI 存储 Dell PowerScale。

Dell PowerScale 文件存储,在功能强大的 NVIDIA DGX SuperPOD 基础架构中提升 AI 工作负载性能。提供可改变行业游戏规则的解决方案,助力企业加速创新并在 AI 计划中实现强大效率。

针对需要高性能数据库解决方案的企业,戴尔引入了基于 NVIDIA GPU 的向量数据库解决方案参考架构。此架构整合了最新的 RAG 技术和向量数据库,优化数据处理和分析能力。

为了支持企业级用户的工程化部署,戴尔结合了 NVIDIA Enterprise、NIM 以及其他硬件基础设施平台。这些参考架构覆盖了从微调、推理到训练等不同的大模型应用场景。所有创新元素和技术细节已经在 GTC 2024 中展示。

写在最后

面向AI时代的产业需求,周元剑 、张旭、吴跃分别就企业 AI 应用、AI 基础设施的发展趋势进行了展望。

周元剑提出了分层实施的策略。他强调,初始阶段的 AI 应聚焦于基层员工的单岗位赋能,如简化报告撰写和数据收集工作。随后,AI 将扩展到多岗位协同,帮助流程中的团队成员进行信息整合和决策支持,最终实现业务流程的自主化。

张旭表达了从硬件到软件的转型和对生态合作的期待,“我们不希望大家都重复去造轮子,希望与各方更多合作。”这表明 NVIDIA 致力于通过简化技术门槛,使大模型服务更加用户友好。”他强调:NVIDIA 将坚守服务大模型客户,简化技术门槛的承诺。

吴跃直言说:“戴尔一直致力于提供一套简单易用的 AI 基础架构。致力于提高计算效率和实现技术架构的端到端简化,使得AI开发者可以将精力集中在更有价值的创新上,而不是硬件和底层工程。”