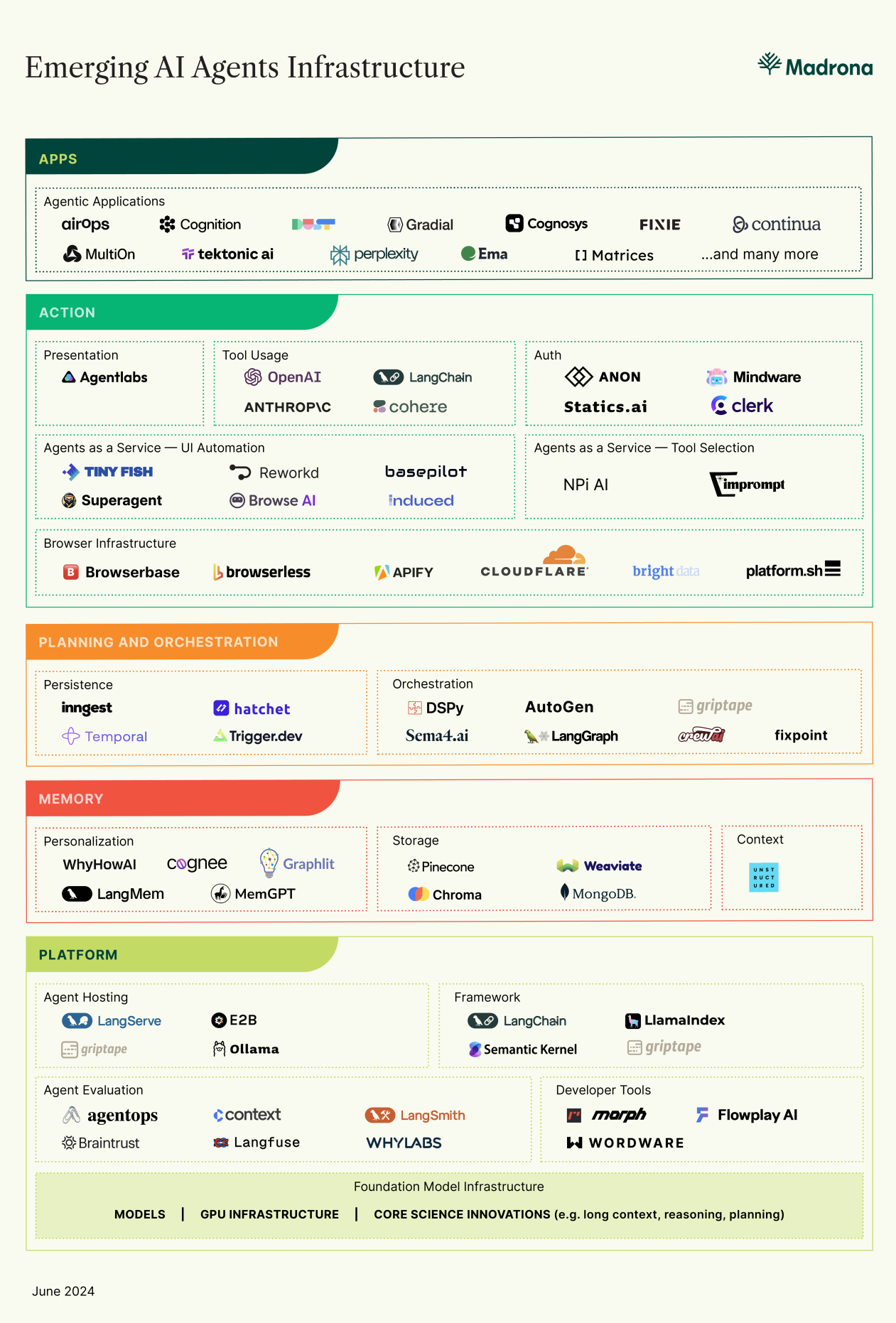

美国风险投资公司Madrona的合伙人Jon Turow近期发表了一篇《AI Agent基础设施的兴起》,分享他对Agent领域的观察和思考,并表示Madrona公司正在积极投资AI Agent、支持Agent的基础设施以及依赖Agent的应用程序。

在这篇行业洞察文章中,Jon Turow谈到,尽管当前Agent存在局限性,但毫不影响Agent正迅速激增的势头,并推动着对新基础设施的需求。而为了更好地释放Agent的潜力,全行业需要发展新的AI Agent基础设施,包括特定的开发工具、Agent即服务、浏览器基础设施、个性化记忆解决方案等等。

Jon Turow呼吁创业者能积极投入到这一新兴领域中,因为AI Agent基础设施的发展在今天尚处于早期阶段,存在着巨大的潜力和发展空间。

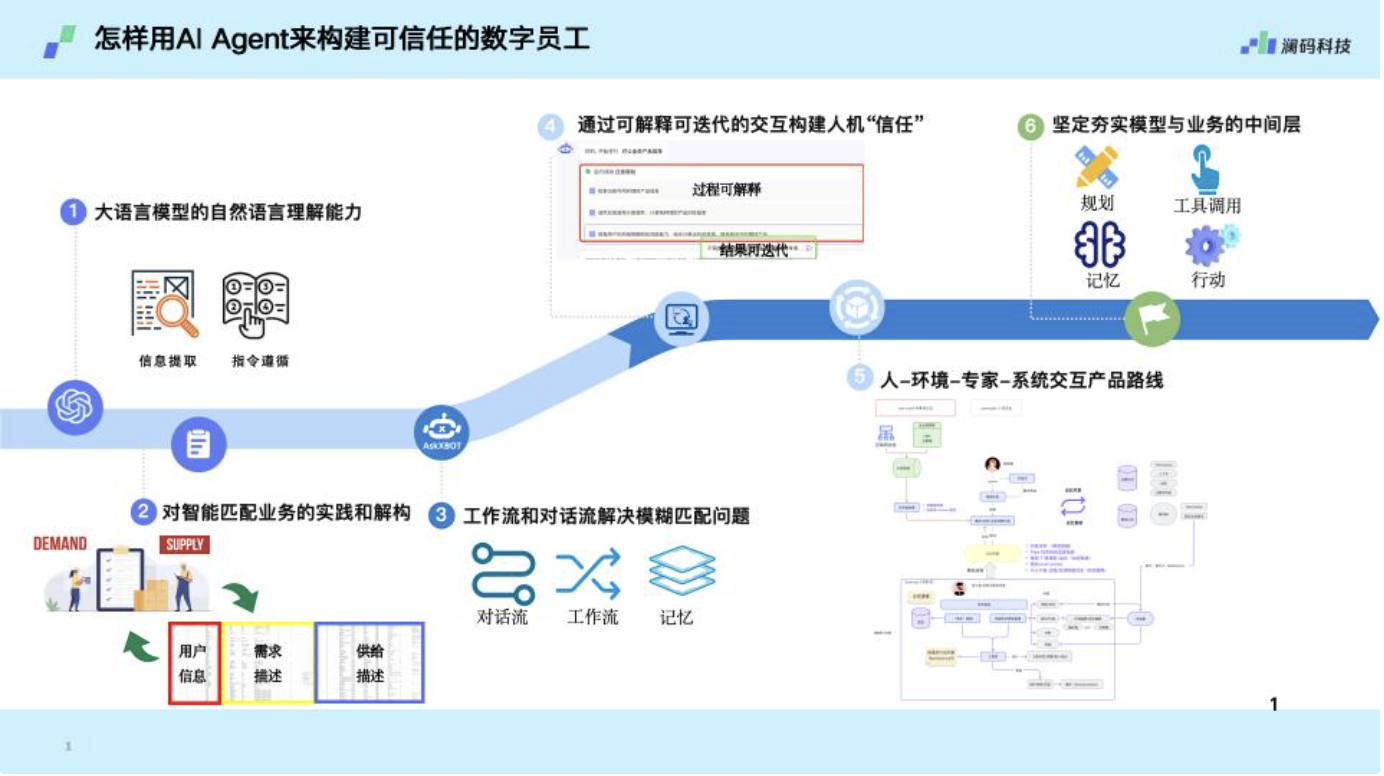

澜码科技在Agent基础设施领域探索了一年多,在我看来,工具使用(Tool Use)和个性化记忆(Personalization Memory)是目前AI Agent最重要的基础设施,这也是澜码科技正在着重做的事情。

在我们大量实践的To B场景中,对于Agent的基础设施建设需求,我们会用Tool Use + Personalization Memory的基础架构路径去承接。

图源:澜码科技

个性化记忆需要世界模型来协助构建

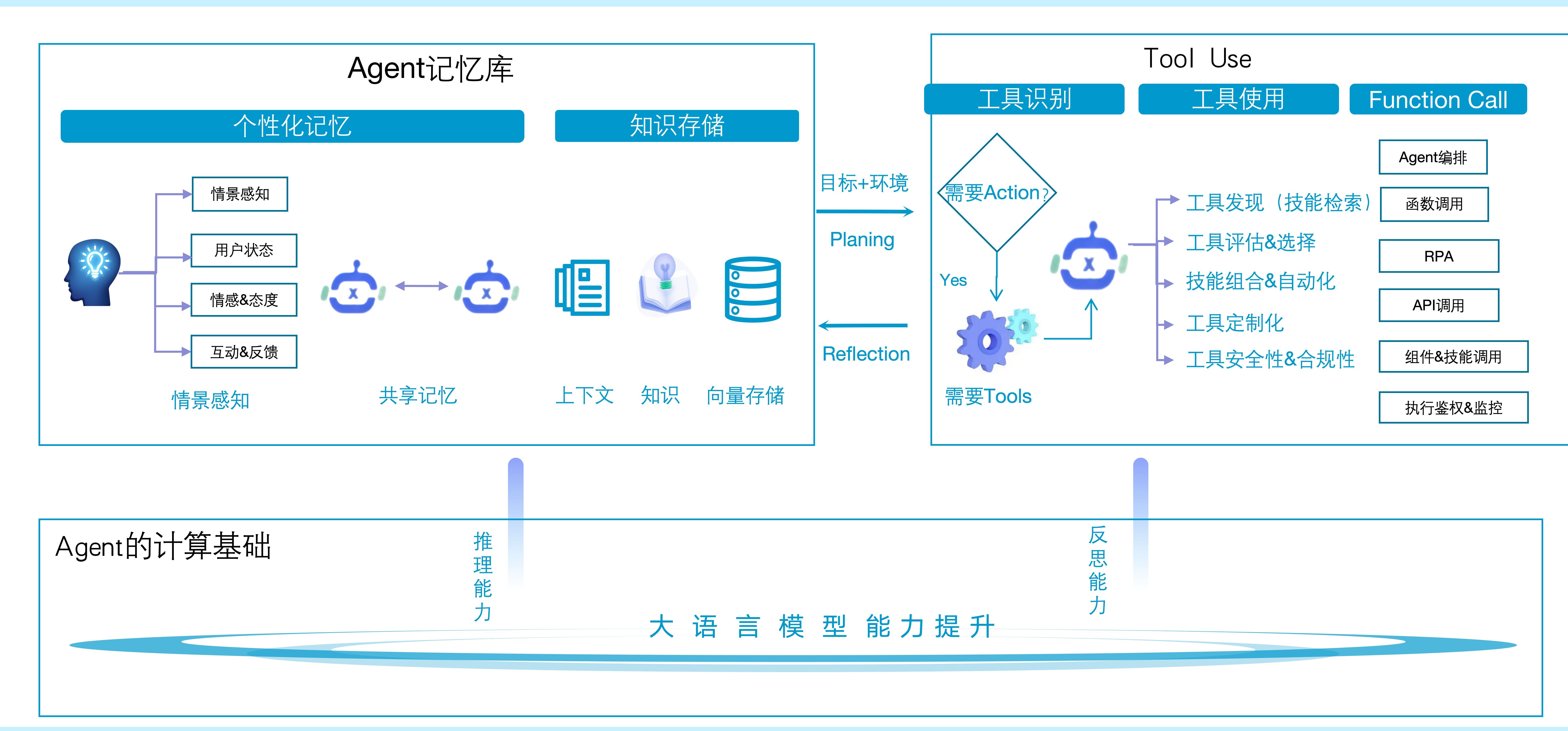

业界有一个精简的Agent表达公示,即:Agent=大模型(LLM)+记忆(Memory)+主动规划(Planning)+工具使用(Tool Use)。基于该公式,一个基于LLM的 AI Agent可以拆分为LLM、规划、记忆与工具使用四个组件部分。

Agent的记忆库负责存储和管理AI Agent在执行任务和与环境交互过程中产生的信息和数据,以支持AI Agent的决策和行为,所以当有决策和行动时,也需要Agent增加Tool Use的能力。

随着大模型自身的发展,特别是大模型在推理能力和反思能力上的增强,Agent平台都需要拥有个性化记忆和工具使用的能力。

在我看来,记忆库不仅仅只是存储,还包括个性化记忆,另外Agent之间共享记忆也很重要。经过一年多实践,我们发现,最难实现的是个性化记忆,个性化记忆还需要与Tool Use结合起来,而个性化记忆需要世界模型来协助构建。

在To B场景下,“世界模型”不仅包括业务流程的脉络、对话或者工作流的上下文和状态,还包括数字世界中的各种系统和智能世界中的其他Agent和员工。有了这些,Agent才能更加准确地理解和预测现实物理世界中的各种情况,并据此作出最佳决策。

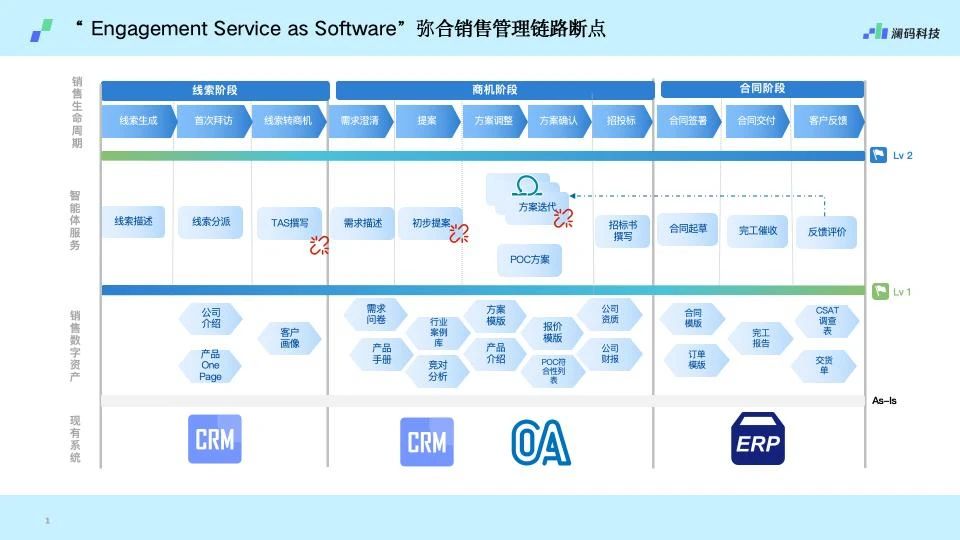

以澜码销售管理Agent为例。我们通过各种视频、书籍、理论等预训练出来一个类似于只拥有数字世界的“销售管理AlphaGo”,然后通过一个优秀的世界仿真器,让“销售管理AlphaGo”通过历史数据以及相应的观测去与真实的物理世界互动,比如可以与一线的人类销售进行对话、主动获取行业动态等,使得它能够更好的与物理世界和数字世界进行观测和互动,最终成为销售负责人的智能助手。

在这个销售管理Agent的构建过程中,专家知识是构建这个独特Agent的“天花板”,因为专家知识——销售负责人的管理理念、风格、策略和其制定的规则,决定了整个Agent的流程、方向甚至是边界。而大语言模型于这个Agent而言,它只是一个底座——负责理解和生成自然语言,使Agent能够更好地与人类员工进行沟通和协作。

为什么Tool Use很重要?

当Agent对Action和目标做完判断,并且判断需要工具时,就进入了Tool Use阶段。

在这个阶段,需要考虑到多Agent协作、Agent编排、函数&API&组件等的调用,同时也包括安全质量相关的鉴权和监控等等。

图源:澜码科技

我们认为,当Agent判断需要有Action时,Function Call(函数调用)能力尤为重要。特别是随着开源模型能力逐渐追平GPT-4,AI Agent将可以依赖Function Call。

Function Call是编程中的一种机制,它允许一个函数(或方法)在另一个函数中执行。为什么Function Call能力尤为重要?

在To B业务场景下,Agent的工作实现方式和路径的关键在于业务目标的实现。这里提到的“业务目标”可以理解为企业在特定时间内期望达成的某个商业成果或状态,实现这个目标的过程,可以被看作是一种“状态机的转移”。

“状态机”是计算机科学中一个常用的概念,它描述了一个系统在不同的离散状态之间转换的模型,在这个模型中,系统可以在多个状态之间根据预设的规则进行转换。在To B业务场景中,每个状态都代表了业务过程中的一个阶段或步骤,状态之间的转化则对应着从当前业务阶段向下一个阶段的过渡。

而在业务流程的状态机模型中,Function Call负责推动状态之间的转换和执行相关的业务逻辑,是实现状态转换、执行业务逻辑和处理业务流程中各种情况的关键机制,通过合理地设计和使用Function Call,可以确保业务流程的顺畅进行,并最终实现企业的业务目标,因此它起着至关重要的作用。

图源:澜码科技

理想情况下,Agent执行完Action后,还需要反馈给记忆模块(Memory)去更新记忆,从而能让Agent更好地处理复杂的任务和场景,提供更加智能和个性化的服务。

2024展望

2024年已过半,大语言模型能力特别是开源模型能力在不断增强、逐步追近GPT-4的水平,然而市场上可见的Agent仍然显得不智能。

在我看来,主要是因为大语言模型的幻觉问题尚未得到有效解决——在完全没有引导的情况下,基于LLM的Agent很难做到“靠谱”,特别是在To B场景下,为了确保Agent的准确率,开发者构建的Agent更偏向自动化而非真正的自主化。

工具使用和个性化记忆两大基础设施的优化和提升有望改变上述状况。

作为一家Agent基础设施服务商,澜码科技在2024年下半年也将聚焦于两件事:

- 集成Function Call的能力,让ToB场景下的Agent/数字员工具备选择工具、使用工具、反思工具的能力;

- 根据多层状态机构建一个目标定义以及怎样完成目标的学习算法。

我们始终认为,Agent规划和完成目标的能力依赖于它在执行过程中的状态(State)和可采取的行动(Action)。特别是在业务流程自动化和数字员工的场景下,Agent为了有效地完成目标,还需要具备相应的领域知识,这些知识可以帮助Agent选择正确的Action,从而推动业务流程的自动化,并最终实现既定的目标。

以下附上《The Rise of AI Agent Infrastructure》原文翻译:

原文传送门:https://www.madrona.com/the-rise-of-ai-agent-infrastructure/

《AI智能体基础设施的兴起》

GenAI应用的爆炸式增长显而易见,应用范围涵盖生产力、开发、云基础设施管理、媒体内容消费,甚至医疗保健收入周期管理等。这种爆炸性增长得以实现,得益于过去24个月快速改进的模型和底层平台基础设施,这些基础设施简化了托管、微调、数据加载和内存,并使构建应用变得更加容易。因此,许多创始人和投资者的目光都转向了软件栈的顶端,我们终于可以开始将最先进的技术用于终端用户。

但生成式AI开发的迅猛速度意味着很少有假设能够长期成立。应用程序现在正以一种新的方式构建,这将对底层基础设施提出新的要求。这些开发者正在一座只完成了一半的大桥上加速前进。如果我们的行业不能在软件栈的更低层次上,用一套新的AI智能体基础设施组件来支持他们,他们的应用程序就无法发挥全部潜力。

智能体的崛起

一个关键的变化是AI智能体的崛起:它们是能够规划和执行多步骤任务的自主参与者。如今,AI智能体——而不是直接面向底层模型的Prompt——正在成为终端用户常见的接口,甚至成为开发者构建的核心。这进一步加快了新应用程序的构建速度,并在平台层创造了一系列新的机会。

从2022年的MRKL项目以及2023年的ReAct、BabyAGI和AutoGPT等开始,开发者们开始发现,提示和响应的链条(chains of prompt and response)可以将大型任务分解为更小的任务(规划)并自主执行。LangChain、LlamaIndex、Semantic Kernel、Griptape等框架表明,智能体可以通过代码与API交互,而Toolformer和Gorilla等研究论文显示,底层模型可以学会有效使用API。微软、斯坦福和腾讯的研究表明,AI智能体协同工作比单独工作效果更好。

如今,“智能体”这个词对不同的人有不同的含义。如果你和足够多的从业者交谈,会发现一系列可以被称为智能体的概念。BabyAGI的创造者中岛洋平(Yohei Nakajima)有一种很好的看待这个问题的方式:

- 定制化的智能体:由提示词和API调用组成的链条,具有一定的自主性,但在狭窄的约束内操作。

- 专业智能体:在任务类型和工具的子集中动态决定要做什么。受到限制,但不如手工设计的智能体那么受限。

- 通用智能体:智能体AGI(通用人工智能)——仍然处于地平线之上,与今天的实际应用相去甚远。

我们最先进的前沿模型(如GPT-4o、Gemini 1.5 Pro、Claude 3 Opus等)在推理上的局限性是制约我们构建、部署和依赖更高级智能体(专业和通用)的关键限制。智能体使用前沿模型来规划、确定优先级和自我验证,即将大型任务分解为小型任务并确保输出正确。因此,适度的推理水平意味着智能体也受到限制。随着时间的推移,具有更高级推理能力的新前沿模型(如GPT-5、Gemini 2等)将使智能体变得更加先进。

应用智能体

如今,开发人员表示,表现最佳的智能体都是高度定制的。开发人员正在研究在当前状态下哪些用例在适当的约束下有效,从而将这些技术应用于他们的工作中。尽管存在局限性,但智能体仍在激增。最终用户有时会意识到它们的存在,例如在Slack上的编码智能体。智能体也会越来越多地被埋没在其他UX抽象层之下,如搜索框、电子表格或画布。

以Matrices为例,这是一家成立于2024年的电子表格应用程序公司。Matrices构建的电子表格能够代表用户自动完成工作,例如,通过根据行和列标题,推断用户想要在A1:J100单元格中输入什么信息,然后搜索网络并解析网页以找到每条数据。Matrices的核心电子表格UX与Excel(1985年推出)甚至Visicalc(1979年推出)并没有太大区别。但是,Matrices的开发人员可以利用1000多个智能体来进行每一行、每一列甚至每一个单元格的独立多步骤推理。

再以Gradial为例,这是一家成立于2023年的营销自动化公司。Gradial让数字营销团队能够自动化他们的内容供应链,帮助创建资产变体,执行内容更新,并在各个渠道之间创建/迁移页面。Gradial提供了一个聊天界面,但也可以通过响应JIRA或Workfront等跟踪系统中的工单来满足市场营销人员现有的工作流程的需求。市场营销人员不需要将高级任务分解为单个动作。相反,Gradial智能体完成了这些工作,并代表市场营销人员在后台完成任务。

当然,今天的智能体还有很多局限性。它们经常出错。它们需要被管理。运行太多智能体会对带宽、成本、延迟和用户体验产生影响。开发人员仍在学习如何有效地使用它们。但读者们应该注意到,这些局限性反映了人们对基础模型的抱怨,这是正确的。验证、投票和模型集成等技术为AI智能体加强了近期GenAI整体所展示的内容:开发人员正指望科学和工程的快速改进,并着眼于未来状态进行构建。他们正在我上面提到的这座“半成品桥”上加速前进,假设它将迅速完工。

为智能体厂商提供基础设施支持

所有这些都意味着我们的行业需要努力构建支持AI智能体及其依赖的应用程序的基础设施。

今天,许多智能体几乎完全垂直集成,没有太多托管基础设施。这意味着:智能体自管理的云主机、用于内存和状态的数据库、从外部来源获取上下文的连接器,以及使用外部API的所谓函数调用、工具使用或工具调用。一些开发人员使用像LangChain这样的软件框架(尤其是其评估产品Langsmith)将东西拼接在一起。这种堆栈在今天效果最好,因为开发人员迭代速度很快,而且他们觉得自己需要端到端控制他们的产品。

但随着用例的巩固和设计模式的改进,未来几个月的情况将发生变化。我们仍然处于定制智能体和专业智能体的时代。因此,短期内最有用的基础设施将是那些能够满足开发人员需求,并让他们构建自己控制的定制智能体网络的工具。这种基础设施也可以具有前瞻性。随着时间的推移,推理能力将逐渐改善,前沿模型将引导更多的工作流程,开发人员将希望专注于产品和数据——这些使他们与众不同的东西。他们希望底层平台能够“无缝运行”,具备可扩展性、性能和可靠性。

确实,当你这样看待问题时,你会发现已经有一个丰富的生态系统开始形成,提供AI智能体基础设施。以下是其中的一些关键主题:

特定的智能体开发工具

像Flowplay、Wordware和Rift这样的工具本身支持常见的设计模式(投票、集成、验证、“团队”),这将帮助更多开发者理解这些模式,并将它们用于构建智能体。一个有用且具有指导性的开发工具,可能是解锁下一波基于这种强大智能体技术的应用程序的最重要基础设施之一。

智能体即服务

为特定任务而定制的智能体开始充当基础设施,开发人员可以选择购买而不是构建。此类智能体提供自定功能,如 UI 自动化(Tinyfish、Reworkd、Firecrawl、Superagent、Induced和Browse.ai)、工具选择(NPI、Imprompt)以及提示词创建和工程。一些最终客户可能会直接应用这些智能体,但开发者也会通过 API 访问这些智能体并将它们组装成更广泛的应用程序。

浏览器基础设施

阅读网页并对其采取行动是一个关键优先事项。开发者通过让智能体与API、SaaS应用程序和网页互动,使他们的智能体更加丰富。API接口相对简单,但网站和 SaaS 应用程序的访问、导航、解析和抓取却很复杂。这样做使得可以使用任何网页或 Web 应用程序,就像使用 API 以结构化形式访问其信息和功能一样。这需要管理连接、智能体和验证码。Browserbase 、Browserless、Apify、Bright Data、Platform.sh和Cloudflare Browser Rendering都是在此领域拥有产品的公司的例子。

个性化记忆

当智能体在多个模型之间分配任务时,提供共享内存并确保每个模型都能访问相关的历史数据和上下文变得重要。向量存储如Pinecone、Weaviate和Chroma对此很有用。但是,一类新的具有补充性、指导性功能的新公司出现了,包括WhyHow和Cognee、LangChain的一个名为LangMem的功能,以及一个流行的开源项目MemGPT。这些公司展示了如何为终端用户及其当前上下文个性化智能体记忆。

智能体授权

这些智能体代表最终用户与外部系统交互,并代表智能体管理身份验证和授权。如今,开发者使用 OAuth 令牌让智能体模拟最终用户(需谨慎),在某些情况下,甚至要求用户提供 API 密钥。但用户体验和安全隐患很严重,而且并非所有网络都支持 Oauth(这就是 Plaid 存在于金融服务领域的原因)。Anon.com 、Mindware和Statics.ai是开发者大规模需要的三个例子:为智能体本身管理身份验证和授权。

“智能体的 Vercel”

使用分布式系统无缝管理、编排和扩展智能体托管。如今,智能体托管(E2b.dev、Ollama、Langserve)、持久性(Inngest、Hatchet.run、Trigger.dev、Temporal.io)和编排(DSPy、AutoGen、CrewAI、Sema4.ai、LangGraph)有一组不同的集合。一些平台(LangChain 和Griptape)为这些事物的不同组合提供托管服务。为应用程序开发人员提供具有持久性和编排功能的可扩展托管的整合服务,将意味着开发者不再需要在多个抽象层次(应用程序和智能体)上思考,而是可以专注于他们希望解决的问题。

构建人工智能智能体基础设施的未来

人工智能智能体基础设施的发展还处于早期阶段,今天我们看到的是一系列运营服务和开源工具,这些工具尚未商业化或整合到更广泛的服务中。而且,谁是最后的赢家还远未明朗 —— 在这个领域,最终的赢家可能今天是年轻的,或者可能尚未存在。所以,让我们开始行动吧。